Espressif เปิดตัวแพลตฟอร์ม ESP Private Agents เพื่อช่วยนักพัฒนาสร้างผู้ช่วย AI แบบทำงานในเครื่อง (local), เป็นส่วนตัว (private) และปรับแต่งได้ สำหรับอุปกรณ์ ESP32 ที่รัน AI บนอุปกรณ์โดยตรง ทั้งยังรองรับงาน AI แบบไฮบริดที่ผสมการประมวลผลบนอุปกรณ์และบนคลาวด์ได้ด้วย

แพลตฟอร์ม ESP Private Agents มีเฟรมเวิร์กแบบรวมศูนย์ที่ช่วยให้นักพัฒนาสร้างแอปพลิเคชันที่ผสานความเร็ว การมองเห็น ระบบอัตโนมัติ และการโต้ตอบแบบเอเจนต์ (agent-based interactions) ตัวอย่างเช่น ผู้ช่วยสั่งงานด้วยเสียงหลายภาษาแบบรันบนอุปกรณ์ (หรือที่เรียกว่า smart speaker) หรือเอเจนต์เชิงงาน (task-oriented agents) ที่ช่วยทำงานอัตโนมัติในเวิร์กโฟลว์ต่าง ๆ

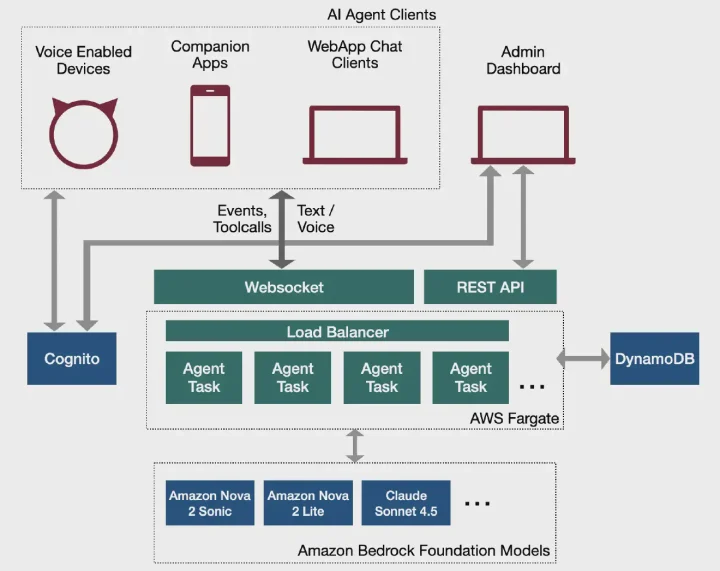

โซลูชันนี้สร้างบนบริการคลาวด์ของ AWS โดยใช้ AWS Fargate เป็นแพลตฟอร์มแอปพลิเคชันหลัก และใช้ Amazon Bedrock Foundation Models เป็นระบบ backend LLM ไม่เพียงรองรับอุปกรณ์พลังงานต่ำตระกูล ESP32 ที่มีลำโพงและไมโครโฟนเท่านั้น แต่ยังทำงานร่วมกับแอปมือถือและเว็บไคลเอนต์ได้ด้วย

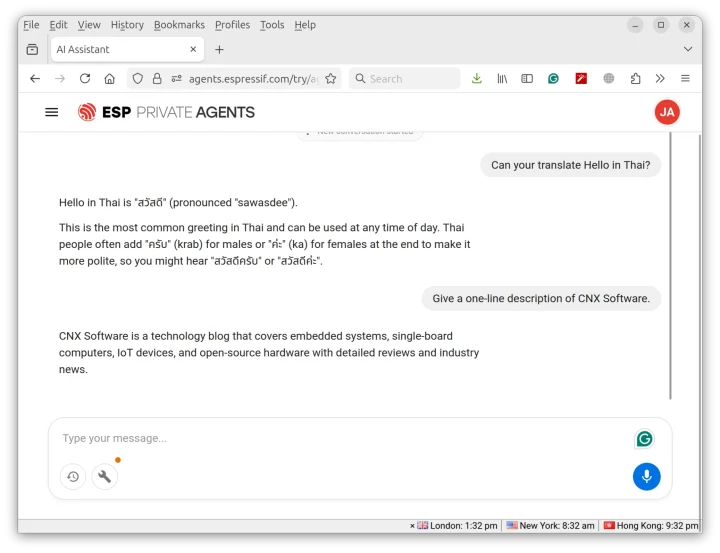

Espressif ได้ปล่อยเดโมแบบเว็บ, ซึ่งคุณสามารถใช้เป็นแชตบอตแบบข้อความ หรือเป็นผู้ช่วยเสียง (voice assistant) โดยอาศัยลำโพงและไมโครโฟนของคอมพิวเตอร์ บริษัทระบุว่าสำหรับการใช้งานจริงในระดับโปรดักชัน ลูกค้าสามารถนำโซลูชันไปติดตั้งในบัญชี AWS ของตนเองได้ ผู้เขียนได้ทดลองใช้งานผ่าน Firefox บน Ubuntu 24.04 หลังจากล็อกอินผ่าน ESP Rainmaker ก็สามารถใช้งานแชตบอตได้ตามปกติ

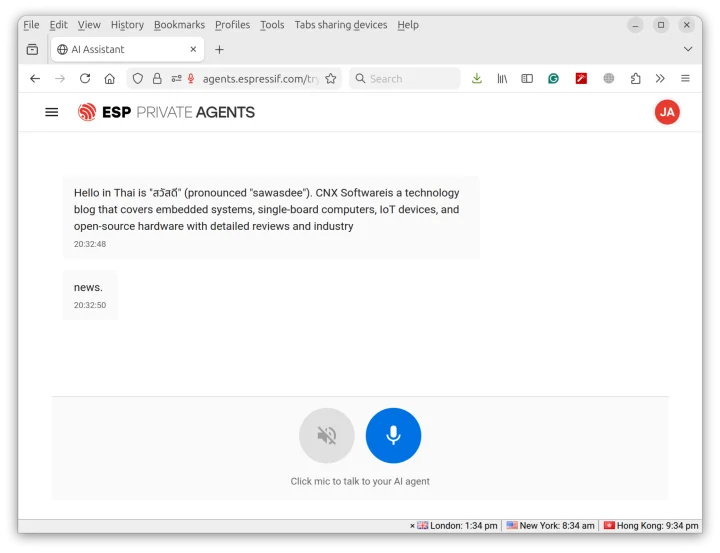

เมื่อคลิกไอคอนไมโครโฟนเพื่อสลับเป็นโหมดเสียง ผู้ช่วยสามารถอ่านคำตอบออกเสียงได้ แต่ไม่สามารถรับเสียงจากผู้ใช้ได้ แม้ระบบจะตรวจพบไมโครโฟนแล้วก็ตาม ผู้เขียนสามารถคลิกไมโครโฟน พูด และกดปุ่มหยุดเพื่อส่งเสียงได้ แต่ก็ไม่มีอะไรเกิดขึ้น ไมโครโฟนบนเครื่องทำงานได้ปกติ จึงอาจเป็นไปได้ว่า ESP Private Agents ยังทำงานกับ Firefox ได้ไม่สมบูรณ์

อย่างไรก็ตาม ยังมีเดโมที่น่าสนใจกว่านี้ โดยใช้ EchoEar hardware เป็นผู้ช่วยเสียง AI หลายภาษา ที่สามารถพูดภาษาอังกฤษ ฮินดี (กำลังจะรองรับ), เยอรมัน และสเปน เมื่อผู้พูดหลายคนสลับกันพูด

ประกาศบนบล็อกนักพัฒนาของ Espressif อธิบายรายละเอียดขั้นตอนการสร้างเอเจนต์ AI และฮาร์ดแวร์ที่เกี่ยวข้องอย่างละเอียด สรุปภาพรวมได้ดังนี้:

- การเลือก LLM จาก Foundation Models บน AWS Bedrock ที่รองรับหลายตัว ซึ่งแต่ละตัวมีประสิทธิภาพ ค่าใช้จ่าย และพฤติกรรมแตกต่างกัน

- System Prompt – ใช้กำหนดพฤติกรรมและบุคลิกของเอเจนต์ เช่น ตัวควบคุมด้วยเสียง นักเล่าเรื่อง หรือผู้ช่วยฝ่ายบริการลูกค้

- Tools – เป็นแอ็กชันแบบเสียบเพิ่ม (pluggable actions) ที่เอเจนต์สามารถเรียกใช้เพื่อทำงานเฉพาะด้าน เช่น ควบคุม ESP RainMaker, ควบคุมระดับเสียง และการตรวจจับอารมณ์ โดยแบ่งเป็น 2 ประเภท :

- Remote Tools ที่รองรับ Model Context Protocol (MCP)

- Local Tools ที่รันโดยตรงบนไคลเอนต์ เช่น อุปกรณ์ IoT เอง หรือแอปมือถือคู่หู ตัวอย่างเช่น การเปิดไฟหรือปรับความเร็วพัดลมระบายความร้อน

เมื่อกำหนดเอเจนต์เรียบร้อยแล้ว สามารถทดสอบได้ทันทีผ่านแดชบอร์ดบนเว็บ ถ้าพอใจกับผลลัพธ์ก็สามารถพัฒนาต่อบนฮาร์ดแวร์จริงโดยใช้ชุดพัฒนาที่รองรับหนึ่งในสามรุ่น ได้แก่ EchoEar, ESP32-S3-Box หรือ M5Stack CoreS3 พร้อมทำตามขั้นตอนดังนี้

- โปรแกรมเฟิร์มแวร์ – ระบบจะสร้างซอร์สโค้ดและไบนารีของเฟิร์มแวร์ให้ ซึ่งสามารถแฟลชผ่านเว็บเบราว์เซอร์ได้ ปัจจุบันมีเฟิร์มแวร์ให้เลือก 2 แบบ : Generic Assistant หรือ ตัวควบคุม Matter ด้วยเสียง พร้อมรองรับ Thread ดูรายละเอียดเพิ่มเติมได้บน GitHub

- Provision อุปกรณ์ โดยใช้แอป ESP RainMaker Home

- กำหนดค่าเอเจนต์ใหม่ลงในอุปกรณ์ (ไม่บังคับ) เพื่อเปลี่ยนเอเจนต์เริ่มต้นที่ทำงานอยู่บนอุปกรณ์ โดยใช้ QR code

- โต้ตอบกับอุปกรณ์ด้วยเสียง

สามารถเข้า agents.espressif.com เพื่อเริ่มต้นใช้งาน

แปลจากบทความภาษาอังกฤษ : The ESP Private Agents platform aims to ease the development of ESP32-based AI voice assistants with on-device processing

บรรณาธิการข่าวและบทความภาษาไทย CNX Software ได้มีความสนใจในด้านเทคโนโลยี โดยเฉพาะ Smart Home และ IoT