CIX ได้เปิดเผยเอกสาร Technical Reference Manual (TRM) สำหรับ SoC รุ่น P1 (CD8180/CD8160) ที่ใช้สถาปัตยกรรม Arm Cortex-A720/A520 อย่างเป็นทางการแล้ว พร้อมกับคู่มือนักพัฒนาสำหรับ GPU (Arm Immortalis G720 และการ์ดจอแยก NVIDIA/AMD), AI accelerator, รวมถึงการติดตั้งและพัฒนาระบบปฏิบัติการ (Android, Linux และ Windows) และเฟิร์มแวร์ (BIOS) ความคืบหน้าที่ช้า (แต่สม่ำเสมอ?) ในเดือนธันวาคม 2024 มีความตื่นเต้นอย่างมากเมื่อเมนบอร์ด Radxa Orion O6 ขนาด mini-ITX เปิดตัว โดยระบุว่าใช้ซีพียู CIX P1 Armv9 แบบ 12 คอร์ ที่ให้ประสิทธิภาพใกล้เคียง Apple M1 และ Qualcomm 8cx Gen3 ในราคาที่เข้าถึงได้เริ่มต้นประมาณ $199 (~6,300฿) สำหรับบอร์ด mini-ITX พร้อมสัญญาการรองรับซอฟต์แวร์ เช่น อิมเมจ Debian, UEFI เต็มรูปแบบ ผ่าน EDKII แบบโอเพ่นซอ […]

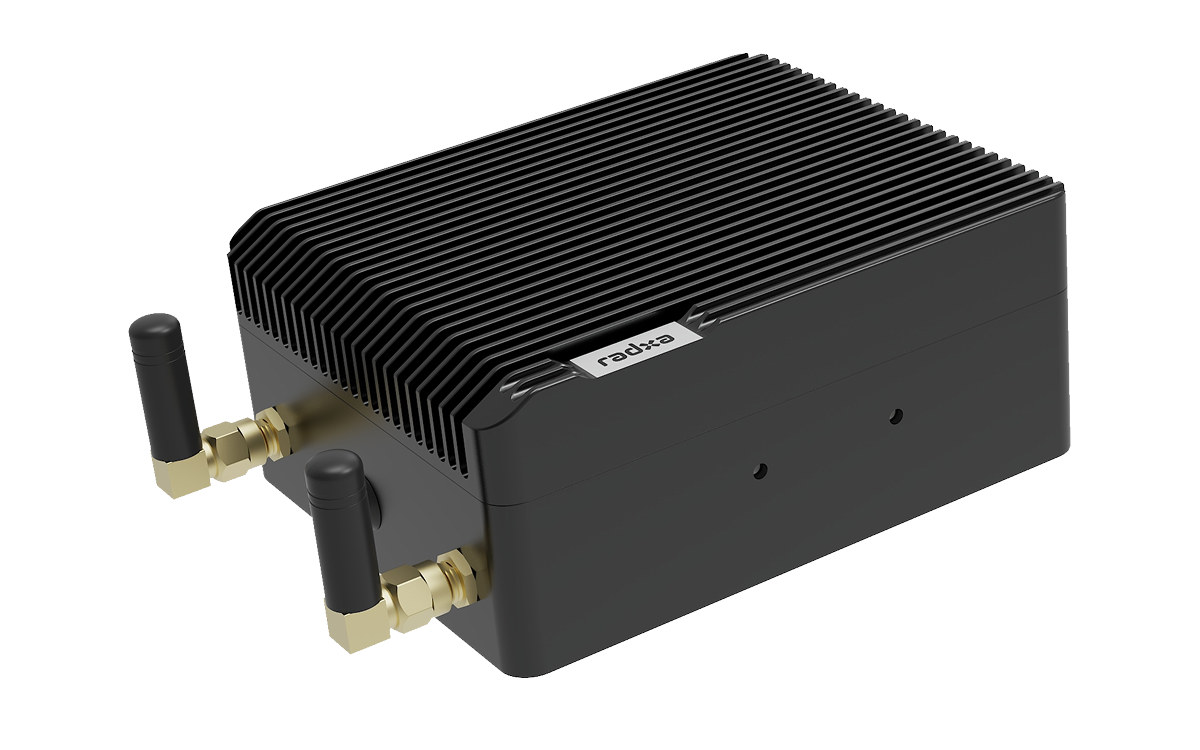

Fogwise AIRbox Q900 : AI Box ที่ใช้ Qualcomm IQ-9075 มีกำลังประมวลผล AI สูงสุด 200 TOPS

Fogwise AIRBox Q900 AI box เป็นรุ่นอัปเกรดของ Fogwise Airbox ที่ใช้ Qualcomm IQ-9075 SoC ซึ่งมีกำลังประมวลผล AI ได้สูงสุด 200 TOPS (sparse) มาพร้อม RAM 36GB และที่เก็บข้อมูลแบบ UFS 128GB Radxa ระบุว่าไมโครเซิร์ฟเวอร์ AI รุ่นใหม่นี้สามารถแข่งขันโดยตรงกับ NVIDIA Jetson Orin NX 16GB, โดยมีต้นทุนระบบโดยรวมที่ถูกกว่า ประสิทธิภาพใกล้เคียงกัน และมีความคุ้มค่าด้านพลังงานมากกว่า นอกจากนี้ยังมีจุดเด่นอื่น ๆ เช่น คอร์ประมวลผลแบบเรียลไทม์ Cortex-R52, การเชื่อมต่อเครือข่าย 2.5GbE และการแยกหน่วยประมวลผล GPU, NPU และ DSP ออกจากกัน สเปคของ Fogwise AIRBox Q900 : SoC – Qualcomm DragonWing IQ-9075 CPU คอร์ประมวลผลแอปพลิเคชัน Octa-core Kryo Gen 6 (พื้นฐาน Cortex-A78C) ทำงานได้สูงสุด 2.36 GHz คอร์เรียลไทม์ Quad-core Cortex-R52 ทำงา […]

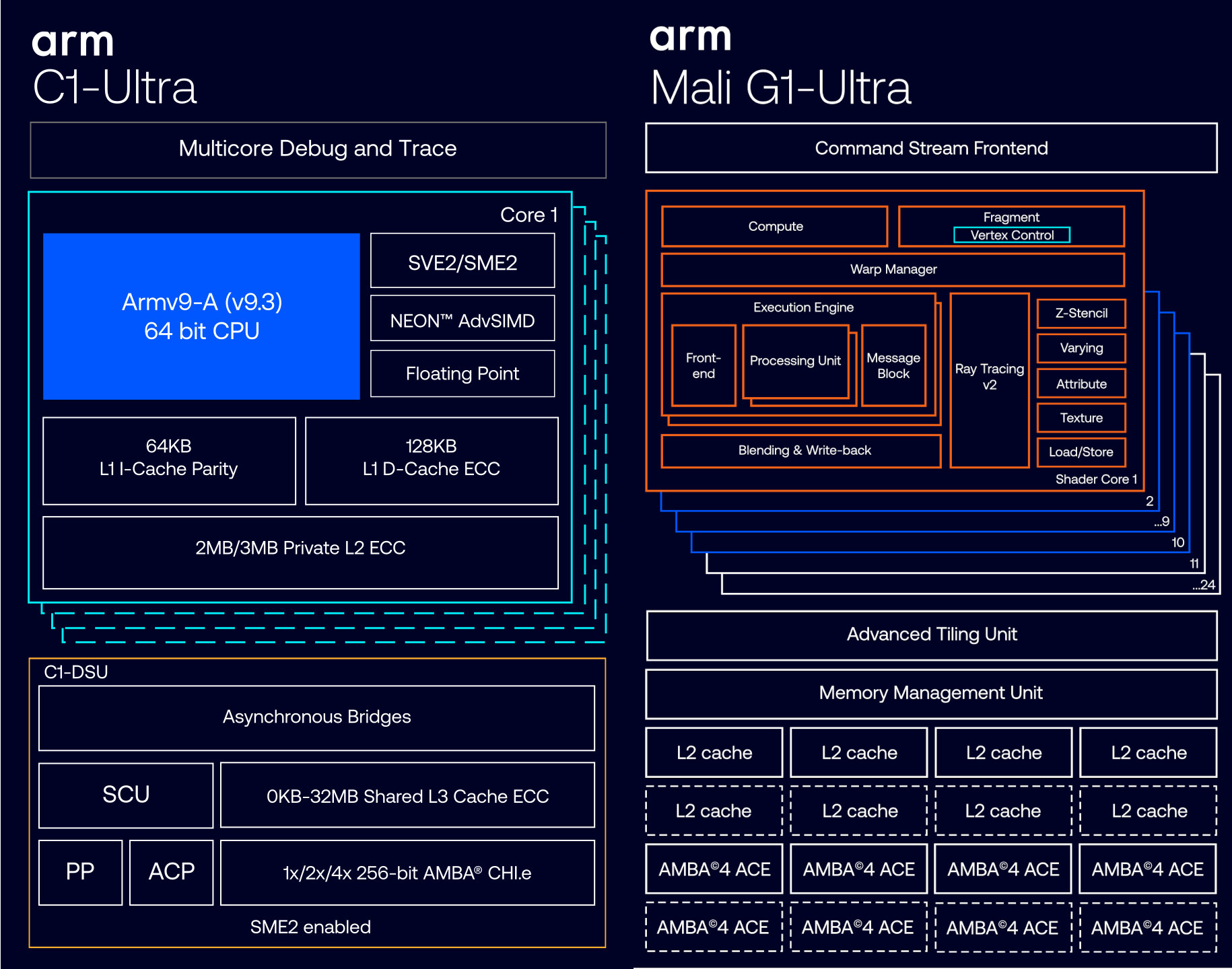

Arm เปิดตัวแพลตฟอร์ม Lumex พร้อมซีพียู C1 ที่รองรับ SME2 สำหรับ Edge AI และจีพียู Mali-G1

แพลตฟอร์ม Arm Lumex CSS (Compute SubSystem) สำหรับอุปกรณ์พกพา มาพร้อมกับซีพียู Arm C1 ที่มีสมรรถนะสูง ทำงานร่วมกับ Scalable Matrix Extension เวอร์ชัน 2 (SME2) และจีพียู Mali-G1 เพื่อรองรับการประมวลผล AI แบบเรียลไทม์บนอุปกรณ์ เช่น ผู้ช่วยอัจฉริยะ การแปลภาษาเสียง และการปรับแต่งการใช้งานให้เหมาะสมกับผู้ใช้ Lumex เป็นส่วนหนึ่งของโครงสร้างการตั้งชื่อผลิตภัณฑ์ใหม่ของ Arm ที่ประกาศเมื่อเดือนพฤษภาคมที่ผ่านมา โดยเจาะจงพัฒนาเพื่ออุปกรณ์พกพาเป็นหลัก Arm ระบุว่า ซีพียูที่รองรับ SME2 สามารถมอบประสิทธิภาพ AI ได้เร็วขึ้นสูงสุดถึง 5 เท่า, ลดความหน่วงของการประมวลผลเสียงลงได้ 4.7 เท่า, และสร้างเสียง (audio generation) ได้เร็วขึ้น 2.8 เท่า. องค์ประกอบของ Lumex: คลัสเตอร์ซีพียู Armv9.3 รุ่นถัดไปที่รองรับ SME2: C1-Ultra สำหรับประสิ […]

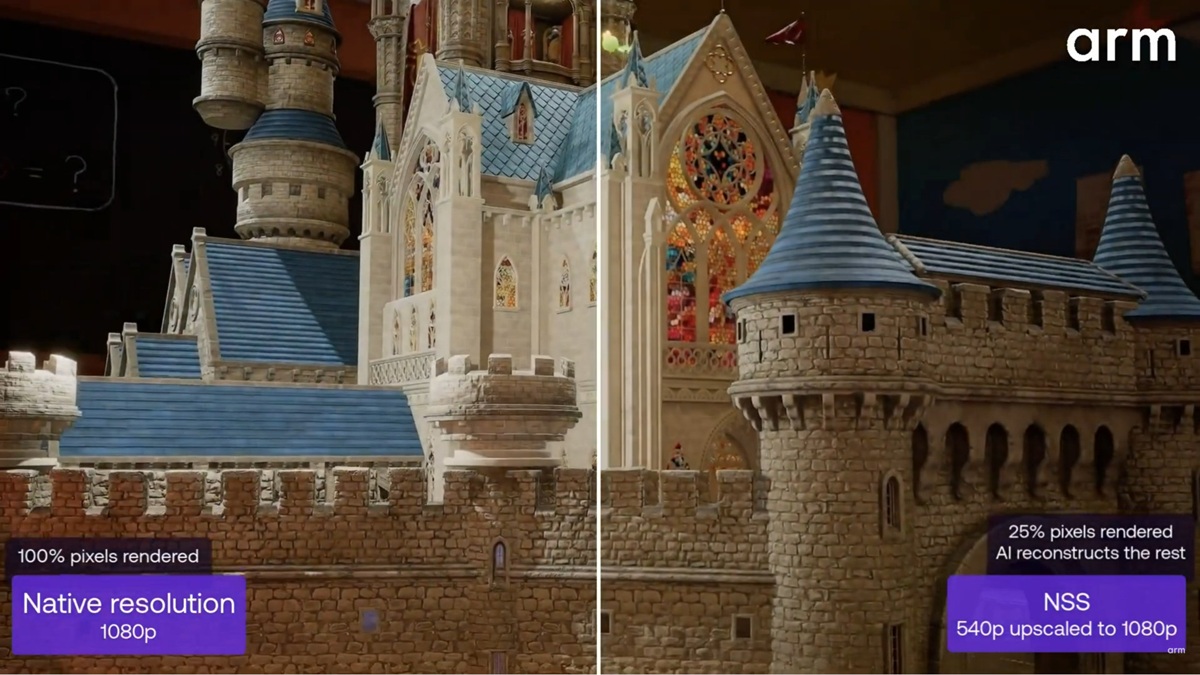

เทคโนโลยี Arm Neural เพิ่ม AI Acceleration ให้กับ GPU รองรับ Neural Super Sampling ลดแบนด์วิดท์ เพิ่มเฟรมเรต

เทคโนโลยี Arm neural จะเพิ่ม Neural/AI accelerators เข้าไปใน GPU ของ Arm ที่จะเปิดตัวในปี 2026 และหลังจากนั้น เพื่อช่วยลดภาระงานของ GPU ได้มากถึง 50% สำหรับเกมบนมือถือและแอปพลิเคชันที่ใช้กราฟิกขั้นสูง แอปพลิเคชันแรกมีชื่อว่า Arm Neural Super Sampling (NSS) ซึ่งเป็นการประยุกต์ใช้ AI Super Resolution สำหรับเกม โดยแทนที่จะอัปสเกลวิดีโอ AI accelerator จะทำการอัปสเกลกราฟิก เพื่อลดการใช้แบนด์วิดท์และเพิ่มอัตราเฟรมเรต (หรือช่วยลดการใช้พลังงาน) โดยไม่กระทบต่อคุณภาพของการเรนเดอร์ ชมวิดีโอตัวอย่างด้านล่าง ซึ่งเป็นภาพที่ GPU เรนเดอร์ที่ความละเอียด 540p แล้วใช้เทคโนโลยี Arm Neural อัปสเกลเป็น 1080p โดยไม่มีข้อบกพร่องที่เห็นได้ชัด ตัวอัปสเกลจะทำให้เกิดความหน่วงเล็กน้อย แต่เพียงประมาณ 4 มิลลิวินาทีต่อเฟรมในสภาวะประสิทธิภาพ […]

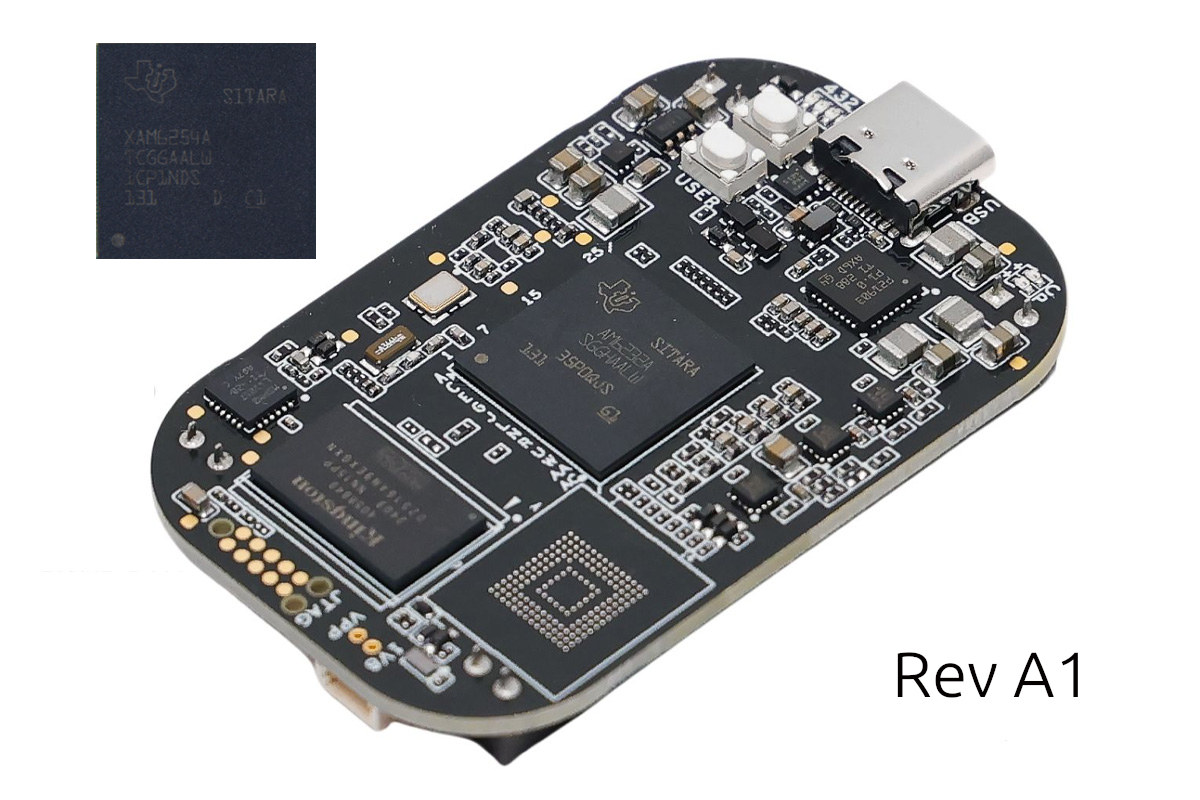

บอร์ด PocketBeagle 2 Rev A1 ใช้ชิป Sitara AM6254 quad-core Cortex-A53/Cortex-M4F พร้อม GPU 3D

PocketBeagle 2 รุ่นแรกเปิดตัวครั้งแรกในเดือนกุมภาพันธ์ โดยมาพร้อมกับชิป Texas Instruments Sitara AM6232 แบบ dual-core Cortex-A53 ความเร็ว 1.0 GHz ที่ไม่มี GPU และใช้บอร์ด PCB รุ่น Rev A0 (รุ่นเดิม), ล่าสุด BeagleBoard.org Foundation ได้เปิดตัวบอร์ดรุ่นใหม่คือ PocketBeagle 2 Rev A1 ใช้ชิป Sitara AM6254 แบบ quad-core Cortex-A53/Cortex-M4F ความเร็วสูงสุด 1.4 GHz และมี GPU 3D ในตัว คุณสมบัติอื่น ๆ ยังคงเหมือนเดิม เช่น ไมโครคอนโทรลเลอร์ Texas Instruments MSPM0L1105 แบบ Arm Cortex-M0+, หน่วยความจำ LPDDR4 ขนาด 512MB, ช่องใส่ microSD cardล พอร์ต USB Type-C สำหรับจ่ายไฟและเชื่อมต่อข้อมูล, พอร์ต Raspberry Pi Debug Probe และ header 36 พิน จำนวน 2 ชุด สำหรับการขยาย สเปคของ PocketBeagle 2 Rev A1 : Main SoC – Texas Instrumen […]

Canonical ปล่อยอิมเมจ Ubuntu 24.04 Desktop สำหรับโปรเซสเซอร์ Qualcomm DragonWing QCS6490 และ QCS5430 แล้ว

Canonical ได้ปล่อยอิมเมจ Ubuntu 24.04 Desktop รุ่นเบต้าแบบสาธารณะสำหรับโปรเซสเซอร์ Qualcomm DragonWing QCS6490 และ QCS5430 แล้ว โดยเฉพาะสำหรับชุดพัฒนา Qualcomm RB3 Gen 2 Vision Kit (QCS6490) และ Qualcomm RB3 Gen 2 Lite Vision Kit (QCS5430) สิ่งนี้เป็นการเพิ่มเติมจากอิมเมจ Ubuntu 24.04 Server ที่มีอยู่แล้วสำหรับชุดพัฒนา Qualcomm Vision Kits โดย Canonical ระบุว่าอิมเมจแบบรวมนี้ออกแบบมาสำหรับนักพัฒนา ผู้ผลิตอุปกรณ์ (ODM/OEM) และลูกค้าที่ต้องการทดลองใช้งานโซลูชันดังกล่าว และจะมีการออกอิมเมจ Ubuntu 24.04 Desktop และ Server เวอร์ชันที่ผ่านการรับรองตามมาภายหลัง ซึ่งจะมาพร้อมการสนับสนุนระยะยาวและการบำรุงรักษาอย่างต่อเนื่อง. Canonical อธิบายว่าอิมเมจนี้ช่วยให้สามารถใช้งาน Ubuntu Desktop ได้อย่างเต็มรูปแบบที่ขอบของเครือข […]

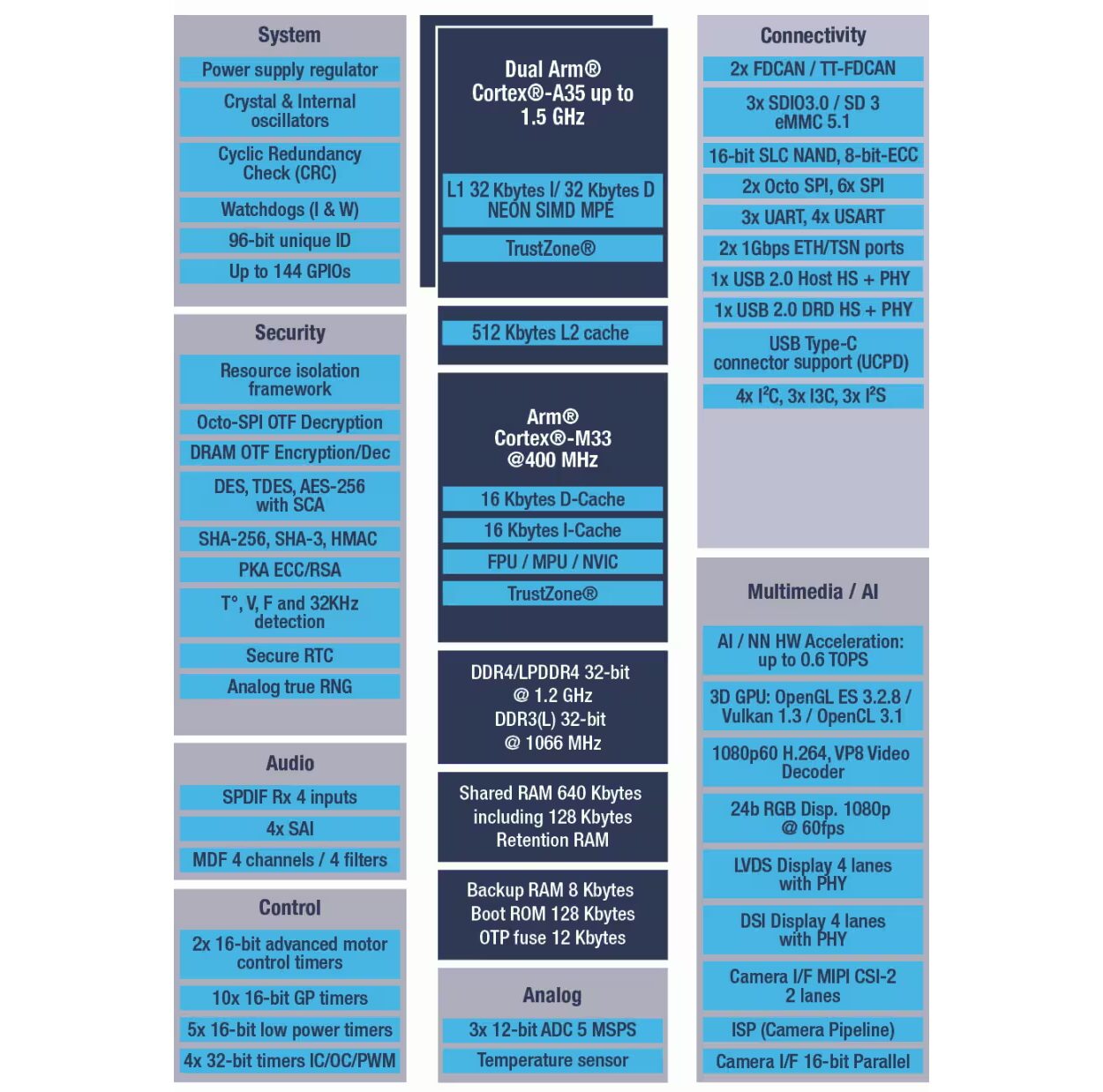

STMicro STM32MP23 : ชิปไมโครโปรเซสเซอร์ (MPU) ที่ใช้ Cortex-A35/M33 พร้อม NPU 0.6 TOPS สำหรับงาน IoT และด้าน ML อุตสาหกรรม

STMicroelectronics STM32MP23 เป็นไมโครโปรเซสเซอร์ (MPU) ที่ใช้ Cortex-A35 แบบ dual-core สำหรับการประมวลผลทั่วไป มาพร้อม Cortex-M33 core สำหรับงานเรียลไทม์ และมีประสิทธิภาพในการประมวลผล 600 GOPS (0.6 TOPS) รองรับการทำงานที่อุณหภูมิสูงสุดถึง 125°C ออกแบบมาสำหรับการประมวลผล Edge Computing ในงานอุตสาหกรรมและ Internet-of-Things (IoT) รวมถึงแอปพลิเคชัน Human-Machine Interface (HMI) ขั้นสูง และงานด้าน machine-learning (ML) ชิปตัวนี้ต่อยอดมาจาก STM32MP25 series ที่เปิดตัวในปี 2023 และวางจำหน่ายจริงในปีถัดมา ซึ่งถือเป็นรุ่นแรกของตระกูล STM32MP2 โดย STM32MP23 เป็นรุ่นราคาประหยัดของ STM32MP25 ที่ยังคงสเปกหลายอย่างใกล้เคียงกัน (รวมถึงใช้แพ็กเกจที่เข้ากันได้แบบ pin-to-pin) แต่มีการปรับลดคุณสมบัติบางส่วน เช่น NPU ที่รองรับได […]

Imagination DXTP GPU ให้ประสิทธิภาพการใช้พลังงานสูงขึ้น 20% เมื่อเทียบกับ GPU DXT สำหรับอุปกรณ์พกพาและแล็ปท็อป

Imagination ได้เปิดตัว GPU DXTP สำหรับอุปกรณ์พกพาอุปกรณ์ที่มีข้อจำกัดด้านพลังงาน โดยให้ประสิทธิภาพการใช้พลังงาน (power efficiency) สูงกว่ารุ่นก่อนหน้าอย่าง D-Series DXT ถึง 20% เพื่อยืดอายุการใช้งานแบตเตอรี่สำหรับแอปพลิเคชัน AI หรือเกมที่ซับซ้อน บริษัทระบุว่า GPU นี้เหมาะสำหรับการเล่นเกม, ส่วนติดต่อผู้ใช้ (user interfaces), แอปพลิเคชันที่เน้นกราฟิก, Computer vision, Generative AI และแอปพลิเคชัน AI อื่น ๆ ที่ออกแบบมาให้ทำงานบนสมาร์ทโฟน, แท็บเล็ต, แล็ปท็อป, เดสก์ท็อป หรือผลิตภัณฑ์ยานยนต์ที่ไม่ต้องการความปลอดภัยระดับสูง จุดเด่นของ Imagination DXTP GPU: มีให้เลือกสองรุ่นหลัก: DXTP-48-1536 48 GPixel/s 1.5 TFLOPS FP32 (1536 FLOPs/Clock) 3 TFLOPS FP16 6 TOPS INT8 48 ppc Bilinear 3D Textured สูงสุด 96 ppc ในโหมด 2D Dua […]